EdTech Thinking #7 - ChatGPT 进化之路

摘要

本周话题:ChatGPT 进化之路

行业:人工智能在教育中的应用——Khanmigo

文章:在人工智能领域,规模大就一定好吗?

教育之美: 如果教师像学生一样行事

封面图

照片为 CeBIT(信息及通信技术博览会) 2007年的展会,学生在试用交互式白板——一块连接计算机的巨大显示屏,可以触摸操作。现今已取代教室中传统的白板、DVD 播放器等设备,据统计,早在2011 年,全球每七间教室中就有一间配备了交互式白板,我认为这是计算机技术对传统教育带来的重大影响之一。

ChatGPT 进化之路

ChatGPT 如此厉害,说实话 OpenAI 的开发者也没有料到。《纽约时报》的一篇文章谈到了它的背后战略,“由于担心对手公司可能会在 GPT-4 之前发布他们的人工智能聊天机器人......” 同时也提到,“即使在 OpenAI 公司内部,ChatGPT 的流行也让人感到震惊。”

2022 年 11 月中旬的一天,OpenAI 的工作人员接到了一个意外的任务:“在两周内快速发布一个聊天机器人。”一位主管宣布,这个聊天机器人将被称为 “Chat with GPT-3.5”,并将免费向公众开放。

这一决定让一些 OpenAI 的工作人员感到困惑。(因为)在过去整整一年中,OpenAI 全员一直在为发布 GPT-4 而努力,这一模型或将在写文章、解决复杂的编码问题等方面有着惊人的表现。据 3 位了解 OpenAI 内部运作的人士称,经过几个月的测试和微调,GPT-4 几乎已经准备就绪,计划在 2023 年初发布,并同时发布一些聊天机器人,让用户自己尝试(定制)。

但是,据了解 OpenAI 的知情人士说,由于担心对手公司可能会在 GPT-4 之前发布他们的人工智能聊天机器人,OpenAI 的高管们决定通过改进于 2020 年推出的 GPT-3 来帮助他们收集反馈意见,进而改进新的模型。

13 天后,ChatGPT 便诞生了。

在 ChatGPT 推出之前,一些 OpenAI 的员工对该项目能否成功持怀疑态度。Meta 公司几个月前发布的人工智能聊天机器人 BlenderBot 已经失败,而 Meta 公司的另一个人工智能项目 Galactica 仅在三天后就被撤下。一些员工由于每天接触最先进的人工智能系统而变得不以为然,他们认为建立在两年前发布的人工智能模型上的聊天机器人可能看起来会很无聊。

也就是说,尽管开发者是在朝着设想改进的方向前进,但能取得如此之大的突破纯属意外。我们不妨站在今天 ChatGPT 取得的成绩前,回头去看看它的成长之路,一窥其中奥秘,从中找到启发。

还不太智能的 GPT-3

2020年5月 GPT-3 发布,它的初代大语言模型名为 Davinci。理论上 GPT-3 系列和 GPT-3.5 系列都是在 Davinci 之上再加工的产物,包括 ChatGPT。

据 OpenAI 官方发布的消息,GPT-3 使用了 45TB 的文本数据进行训练,可以想象成100万个受过良好教育的人终身的阅读量。至于训练时间,没有公开具体的数字,估计达到了数千小时或更长时间。OpenAI 称所有模型都在微软提供的超级计算机系统上训练,该系统据称拥有超过285000个 CPU 核心、10000 个 GPU 和每秒 400G 的网络。在超大算力资源的加持下,GPT-3 训练一次的费用是460万美元,训练时间为355个 GPU 年,总成本据悉达到1200万美元。由于代价高昂,论文中直接承认出现 BUG 时无法中止再重新开始,只训练了一次。

在计算机自然语言处理(NLP)领域,语言模型是重要工具,基本原理是对语句分布概率建模,传统的语言模型需要测试开发者采集大量训练数据进行调优,之后才能应用到下游的具体 NLP 任务中,调优过程耗时长且代价高昂。但 OpenAI 所推出的模型仅需要文本交互和给予少量示例,即能完成翻译、问答和文本填空等任务,这源于 GPT-3 高达1750亿的巨大参数量,是前一代的116倍,效果如同烧钱“暴力”提高 AI 准确率。它展示了三个令人震撼的能力:

语言生成:遵循提示词(prompt)生成补全的句子。

上下文学习 (in-context learning): 遵循给定任务的几个示例为就能生成解决方案。重要的是不需要重新训练就可以。

世界知识 (world knowledge):包括丰富的事实性知识 (factual knowledge) 和常识 (commonsense)。

这些重要能力背后靠的是巨大的资源数量,但是很遗憾,它仍然没有语义理解和因果推理能力。也就是说除了成本,在真正的智能以及实用性方面,GPT-3 仍然饱受质疑。人们普遍认为 GPT-3 展现了规模变大后模型的能力,但离实用还很远。OpenAI 的 CEO Sam Altman 也表示:

GPT-3 被讨论得太过了,它的确令人眼前一亮,但是它还有很多缺陷甚至有时会犯愚蠢的错误,AI 将会改变世界,但 GPT-3 还只是很早的一瞥,我们还有问题需要解决。

其实初代 GPT-3 在许多任务上的表现还不如 T5,后者是成本低很多用专门数据精调过的小模型。综合来看 GPT-3 表现很难算“智能”,只能是“有用,但是也挺蠢”。直到 ChatCPT 的问世,才彻底改变了人们对于大模型的认知。

下面这张图是出自爱丁堡大学 (University of Edinburgh) 博士生符尧作为第一作者的一篇博文,已经被很多地方引用,它非常清晰得描述了 GPT-3 系列和 GPT-3.5 系列的进化之路。下面将按图索骥,看看发生了什么,ChatGPT 突然变得如此聪明。

初露锋芒之 GPT-3.5

我们可以把目光跳过2021年8月发布的 Codex Initial,和2022年3月的 InstructGPT Initial, 直接聚焦到位于图1中间区域的 Code-davinci-002,它站在前面二者成功的肩膀之上。2022年5月,Code-davinci-002 随发布代号为 Text-davinci-002 的新版大模型被一起披露。按照 OpenAI 官方文档的说法,它是 GTP-3.5 系列的基础模型,开启了 GPT-3.5 时代。

Code-davinci-002 和它的初代 Code-davinci-001 共用同一个生产版本名字 Codex,被用在 GitHub Copilot 中。这个工具可以在 VS Code 编辑器中自动完成代码片段,也是 OpenAI 拿了微软 10 亿美元之后的第一个重大成果。Codex 模型可以将自然语言描述转换为代码。而效果吗,看看程序员们对 Copilot 的赞不绝口就知道了。AI 生成代码的时代终于到来。

Code-davinci-002 和 Text-davinci-002,这两兄弟一个用于代码,另一个用于文本。它们表现出了四种优于初代 GPT-3 的重要能力:

响应人类指令:以前,GPT-3 基本是按照训练中常见的提示词补全模式输出。现在的模型会针对指令 / 提示词生成更合理的答案,而不是相关但无用的句子。

泛化到没有见过的任务:当用于调整模型的指令数量超过一定的规模时,模型就可以自动在从没见过的新指令上也能生成有效的回答。 这对于商用至关重要,因为用户总会提新的问题,模型得答得出来才行。

代码生成和代码理解:这个能力很显然,因为模型用代码训练过。

利用思维链 (chain-of-thought) 进行复杂推理:初代 GPT3 的模型思维链推理的能力很弱甚至没有。

code-davinci-002和text-davinci-002是两个拥有足够强的思维链推理能力的模型。

思维链推理对“智能”非常重要,因为思维链可能是解锁涌现能力(emergent ability)的关键。我们先来理解什么是涌现,再解释思维链。

什么是涌现

“涌现”理论的主要奠基人是约翰·霍兰德,他在《涌现:从混沌到有序》中描述了这种现象:

就如蚂蚁社群、神经网络、免疫系统、互联网乃至世界经济,但凡一个过程的整体行为远比构成它的个体累加复杂,均可称为“涌现”现象。通常说来,“涌现”指一个系统中个体间预设的简单互动行为所造就的无法预知的复杂样态的现象。

例如:在凝聚态物理中“涌现”一词常用来描述随着粒子数目增多,突然出现的奇异现象;一只蚂蚁🐜很弱小,它没什么脑子,没有欲望,没有计划,但如果是很多蚂蚁聚集在一起,它们就变得相当聪明。

简而言之,小个体组成整体,整体属性却不同于个体累加之和。涌现是由简生繁的过程,它无处不在。

超越缩放法则

人们非常期待大语言模型的涌现能力出现,是因为缩放法则 (scaling law)在某些方面已经锁定了人工智能的发展,而涌现能力就是超越缩放法则的关键。

一、数据总规模受困于缩放法则

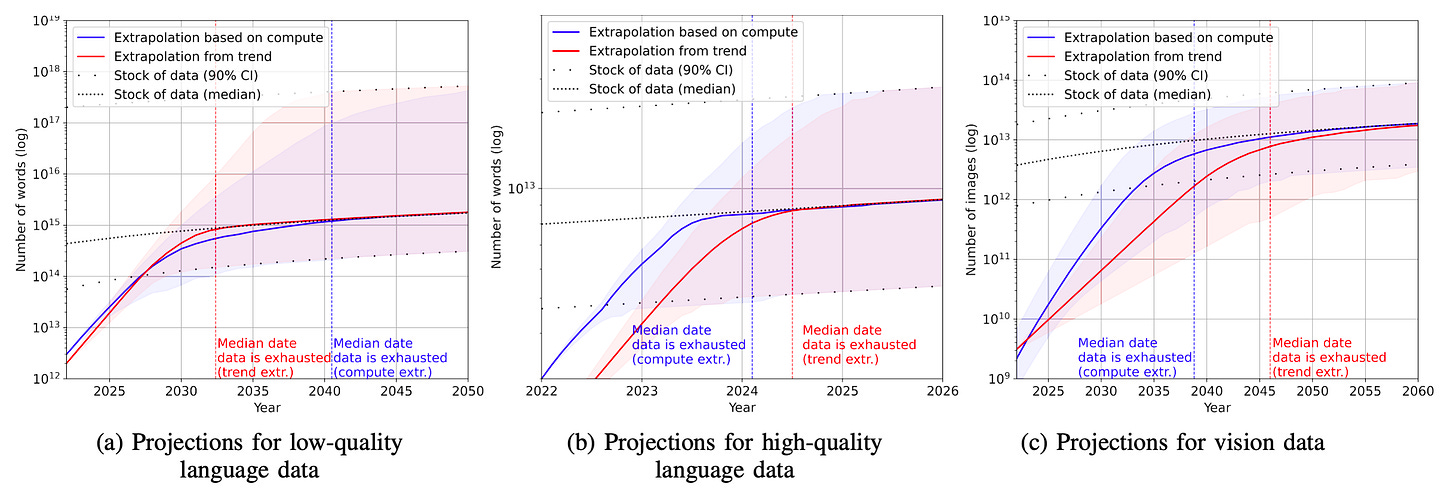

语言模型的缩放法则表明,其规模大小取决于可用数据的数量。所以在过去几年,大约有一半的语言模型是通过扩大数据量来改进性能的。但模型能不能做大的问题已经出现了。2022年10月,一项来自 Epoch AI Research 团队的研究抛出了一个残酷的事实:模型还要继续做大,数据却不够用了。研究人员预测了 2022 年至 2100 年间可用的图像和语言数据总量,并据此估计了未来大模型训练数据集规模的增长趋势。

结果表明:高质量的语言数据存量将在 2026 年耗尽,低质量的语言数据和图像数据的存量将分别在 2030 年至 2050 年、2030 年至 2060 年枯竭。这意味着到 2040 年模型的规模增长将放缓,如果没有有新的数据源可用,解决这个问题只能依赖使用数据效率的显著提高了,即突破缩放法则。

二、性能被缩放法则锁定

最初,人们相信性能与模型大小的关系可以通过对数线性曲线来预测,即遵照缩放法则,性能随着模型大小的指数增长而线性增加。

具有讽刺意味的是,在2020 - 2021年 GPT 的缩放法则年代,采用 prompt 方式的 GPT-3 的性能在很多方面却无法超越采用微调(fine-tuning)的 T5-11B。相比 T5 的11亿参数规模,GPT-3 的1750亿已经大很多。

那么耗费巨资和大量时间训练大语言模型还有什么意义?如果微调更好,我们应该投入更多的精力在参数有效调优(parameter-efficient tuning)上,而不是训练大语言模型。

不幸的是,2021年 Cobbe 等发表论文 Training Verifiers to Solve Math Word Problems,缩放法则在微调领域也被证实。眼睁睁两条路线都要被锁定。符尧在其另一篇博文中这样描述:

这是相当悲观的,因为这意味着我们也许被锁定在我们的模型规模上——模型架构的不同调整可能在一定程度上改善了模型的性能,但是,我们似乎仍然被锁定在其相应的规模范围内,不能有显著的性能突破。

转机发生了

2022年1月下旬思维链突然出现,故事也就开始了。思维链提示在性能规模曲线上表现出明显的阶段性变化(phase change)。当模型规模足够大时,性能显著增加并明显超越了缩放曲线。

复杂推理方面,具备思维链的模型明显优于微调的性能,在知识推理上也有竞争力,而且还有分布式鲁棒性的潜力。所有这些优势只需要提供大约8个上下文(in-context)的例子就能展现。

思维链解锁涌现能力

ChatGPT 可以以流畅、符合逻辑的自然语言来反馈人类对它输入,从而给与它交流的人带来了很强的与真人交流的感受。这其中的逻辑推理能力,是随着思维链能力的出现而明显增强的。正如前所述,这项能力初代 GTP-3 并不具备,它好像在2022年初突然“涌现”了。

所谓思维链,就是大模型在输出时不仅可以给出结果,还能拆解复杂推理步骤一步步推导。你可以试试向 ChatGPT 提问时,只要加上一句“请一步一步来”,它就能给出更好的答案。

但实际上模型在训练的时候,开发人员并没有针对逻辑推理以及思维链做特定的设计。当前的主流观点认为,逻辑推理和思维链的涌现很可能和两个因素相关:

第一个是模型的体量。

第二个是模型是否在代码数据上进行过训练。

模型体量决定了思维链的产生

2022年一月发布的论文 Chain-of-Thought Prompting Elicits Reasoning in Large Language Models **中有一张图:

GSM8K,SVAMP 和 MAWPS 是三个需要逻辑推理的数学应用题数据集,LaMDA,GPT 和 PaLM 分别是 3 个不同的模型。简要地说,图表中给出了三个不同的模型,在三个数学应用题数据集上的答对率。而值得关注的是以下几个方面:

思维链能力(蓝色实线)是突然涌现的。当参数规模超过千亿时,思维链能力呈指数级爆发。

思维链的能力在模型够大的前提下,效果超过了标准的指令(standard prompting,黑色实线)方法;

思维链的能力在模型够大的情况下,可以接近甚至超过有监督的方法(橙色虚线);

根据目前观察,参数达到千亿以上的大模型才可能拥有强大的思维链能力,而这只是必要条件:有些千亿参数大模型没能展现出思维链能力。

用通俗的话来说,就是在模型足够大的时候,思维链的能力突然展现了出来,能够达到、甚至超过那些在推理数据集上专门进行有监督训练的模型。这个图也许部分解释了现在我们看到的 ChatGPT 所具有的优异推理和思维链能力。同时不要忘记千亿大模型只是必要条件,只有这还远远不够(GTP-3 和 Meta OPT 就是例证)。

代码训练可能才是关键

从图1中可以看出 Code-davinci-002 是代码训练(code training)和指令微调(instruction tuning)结合的产物。

据说是符尧首先提出这个猜测:Codex Initial 可能就已经具备执行复杂推理的能力,得益于 GitHub 代码的训练。代码比自然语言更富有逻辑,面向过程的语言展现按序解决任务的思路,而面向对象的语言模拟了人类把复杂事物拆解的能力。

事实上,根据 OpenAI 的内部研究,初始版本的 GPT-3 思维链能力也很弱,而以 Code-davinci-002 为基础的 GPT-3.5 系列则体现了很强的思维链能力。因此,一个有趣的假设是,GPT-3.5系列思维链能力的"涌现",除了达到千亿参数的基础条件外,GPT-3.5 系列的基础核心模型是依赖于代码(Code)大数据训练,而不是普通文本(Text)训练。如果这个推断没有错,那么众多 ChatGPT 的追随者们,如希望自家能力真正比肩基于 ChatGPT, 那必须要补的一课就是代码数据的训练了。

根据符尧的推论 Code-davinci-002 很可能是最强大的 GPT-3.5 变体。它的基础模型应该不是 Davinci,而是基于比初代 GPT-3 更大的模型。再加上大规模代码的支持,可以说它已经具备了 ChatGPT 所有的能力,后面的操作都是在解锁或激发后续模型展现出的能力。

尽管 Codex 听着像是一个只管代码的模型,但

Code-davinci-002可能是最强大的针对自然语言的 GPT-3.5 变体(优于之后的Text-davinci-002和-003)。

指令微调让 “我“更像一个人

ChatGPT 可谓“能力强大,善解人意”。至此,Code-davinci-002 已经赋予 ChatGPT 强大的能力。那是如何让它做到善解人意的呢?

按图2所示,从 Code-davinci-002 到 Text-davinci-002 再到ChatGPT 中间还执行了两次指令微调:

有监督指令微调 (supervised instruction tuning)

基于人类反馈的强化学习(RLHF,Reinforcement Learning from Human Feedback)指令微调

这个过程注入新知识了吗?应该是注入了,这些知识就包含在几万人工标注数据里,不过注入的不是世界知识,而是人类偏好知识。人类偏好知识反应在以下两方面:

首先,是人类表达一个任务的习惯说法。比如,人习惯说:“把下面句子从中文翻译成英文”,以此表达一个“机器翻译”的需求,但是大模型又不是人,它怎么会理解这句话到底是什么意思呢?你得想办法让大模型理解这句命令的含义,并正确执行。所以,在有监督指令微调阶段,下图中的 Step 1,通过人工标注数据,向大模型注入了这类知识,方便它理解人的命令,这是它“善解人意”的关键。

其次,对于什么是好的回答,什么是不好的回答,人类有自己的标准,例如比较详细的回答是好的,带有歧视内容的回答是不好的,诸如此类。这些人类自身对回答质量好坏的偏好,通过基于人类反馈的强化学习(RLHF)指令微调告诉大模型,如上图 Step 2、3 所示。

强化学习是机器学习中的一个领域,强调如何基于环境而行动,以取得最大化的预期利益。强化学习是除了有监督学习和非监督学习之外的第三种基本的机器学习方法。与有监督学习不同的是,强化学习不需要带标签的输入输出对,同时也无需对非最优解的精确地纠正。其关注点在于寻找探索(对未知领域的)和利用(对已有知识的)的平衡。

非常有趣的是,其灵感来源于心理学中的行为主义理论,即有机体如何在环境给予的奖励或惩罚(负奖励)的刺激下,逐步形成对刺激的预期,产生能获得最大利益的习惯性行为。

简单的说,强化学习就是通过奖励模型(reward model)来训练 GPT。你在和 ChatGPT 聊天时也可以给 OpenAI 提供这样的信息,每个对话气泡右侧的小手就是在收集奖励反馈。

这项技术在 2022年3月发布的 InstructGPT 训练中就已经被应用,论文 Training Language Models to Follow Instructions with Human Feedback 给出了说明:

我们专注于调整语言模型的微调方法。具体来说,我们使用来自人类反馈的强化学习来微调GPT-3,使其遵循一大类书面指令。这项技术使用人类的偏好作为奖励信号来微调我们的模型。我们首先雇用了一个由40名承包商组成的团队,根据他们在筛选测试中的表现,为我们的数据贴上标签……这个过程使 GPT-3 的行为与特定人群(主要是我们的标签人员和研究人员)的声明偏好相一致,而不是任何更广泛的 "人类价值 "概念。

ChatGPT 在 Text-davinci-002 基础之上进行 RLHF 指令微调后,很多性能都不如 Code-davinci-002 ,并且似乎牺牲了几乎所有的上下文学习能力(从 Code-davinci-002 到 Text-davinci-002已经失去了一些),但增强了零样本(zero-shot)能力。这也许更符合人类的期待,要为每个任务都写上下文示例实在太麻烦。总之, ChatGPT 最后得到了更宝贵的能力:

翔实的回应:

Text-davinci-003的生成通常比Text-davinci-002长。 ChatGPT 的回应则更加冗长,以至于用户必须明确要求“用一句话回答我”,才能得到更加简洁的回答。这是 RLHF 的直接产物。**公正的回应:**ChatGPT 通常对涉及多个实体利益的事件(例如政治事件)给出非常平衡的回答。这也是RLHF的产物。

**拒绝不当问题:**这是内容过滤器和由 RLHF 触发的模型自身能力的结合,过滤器过滤掉一部分,然后模型再拒绝一部分。

**拒绝其知识范围之外的问题:**例如,拒绝在2021 年 6 月之后发生的新事件(因为它没在这之后的数据上训练过)。这是 RLHF 最神奇的部分,因为它使模型能够隐式地区分哪些问题在其知识范围内,哪些问题不在其知识范围内。

通过上缴 OpenAI 的作者在他们的论文中所称的“对齐税”(alignment tax),ChatGPT 性能虽然降低,但更像一个可靠的人类:回答中立、客观、安全和翔实。ChatGPT 输入框下有一行他们的目标:

Our goal is to make AI systems more natural and safe to interact with.

ChatGPT 就像一个人类的孩子被送到学校,老师们尽自己所能教育孩子。她在里面学习了海量的事实和常识(Davinci),练就了解决新任务的本领,还用代码培养了逻辑推导(Code-davinci-002),已然具备了超强的解决通用问题的能力,但还不能说她已经是一个合格的公民,她必须接受社会的规范(Instruction tuning + RLHF)的指引和约束。

一路走来,最终 ChatGPT 出现在世人面前。

惊世骇俗!

附录1:GPT-3.5 的演化路径表(符尧)

附录2: 中英术语对照表(符尧)

参考资料

《拆解追溯 GPT-3.5 各项能力的起源》(2022),符尧等,“https://yaofu.notion.site/GPT-3-5-360081d91ec245f29029d37b54573756”

Chain-of-Thought Prompting Elicits Reasoning in Large Language Models (2023), Jason Wei et al., “https://arxiv.org/abs/2201.11903”

Training Language Models to Follow Instructions with Human Feedback (2022), Long Ouyang et al., “https://arxiv.org/abs/2203.02155”

Training Verifiers to Solve Math Word Problems (2021), Karl Cobbe et al., “https://arxiv.org/abs/2110.14168”

A Closer Look at Large Language Models Emergent Abilities (2022), Yao Fu, “https://yaofu.notion.site/A-Closer-Look-at-Large-Language-Models-Emergent-Abilities-493876b55df5479d80686f68a1abd72f”

大模型“研究源”告急:研究预测,2026年高质量语言数据将耗尽 (2022),李梅,“https://www.leiphone.com/category/academic/lotDInkoghMK3rr0.html”

Will we run out of data? An analysis of the limits of scaling datasets in Machine Learning (2022), Pablo Villalobos et al., “https://arxiv.org/abs/2211.04325”

维基百科(2023)强化学习,“https://zh.wikipedia.org/wiki/强化学习”

Understanding Zero-Shot Learning — Making ML More Human (2021), Ekin Tiu, “https://towardsdatascience.com/understanding-zero-shot-learning-making-ml-more-human-4653ac35ccab”

ChatGPT是如何掀起AI军备竞赛的?(2023),学术头条,“https://www.thepaper.cn/newsDetail_forward_21829985”

How ChatGPT Kicked Off an A.I. Arms Race (2023), Kevin Roose, https://www.nytimes.com/2023/02/03/technology/chatgpt-openai-artificial-intelligence.html

AGI的进化编年史(2023),Web3天空之城,“https://mp.weixin.qq.com/s/8rgXSjXMQhv_Zs99ZboCkg”

ChatGPT的前世今生:OpenAI的技术「执拗」与「豪赌」(2023),追一科技,“https://mp.weixin.qq.com/s/rNVhDjFeamxYiqo8dfYclw”

任何事物都有的现象:涌现,以及由涌现产生的意识(2023),风林木鱼,“https://zhuanlan.zhihu.com/p/130736356”

零样本思维链 (2023),learnprompting.org, “https://learnprompting.org/zh-Hans/docs/intermediate/zero_shot_cot”

奇点前夜还是算力极限?OpenAI史上最大语言模型引争议(2020),林芯芯,“https://m.sfccn.com/2020/8-27/xNMDE0MDdfMTU4NjMxNw.html”

通向AGI之路:大型语言模型(LLM)技术精要(2023),张俊林,“https://zhuanlan.zhihu.com/p/597586623”

ChatGPT (Mar 14 Version), ”https://chat.openai.com/chat”

行业

人工智能在教育中的应用——Khanmigo

可汗学院与 OpenAI 的合作项目——Khanmigo,旨在让学生拥有一个随时可与之对话的机器人导师,并且该机器人还能协助教师完成一些行政任务。

可汗学院是一个在网络上提供免费课程的网站,课程形式主要是特别录制的教学视频和练习题,内容涵盖数学、历史、医学、金融、物理、化学等数十门课程。据维基百科记载,可汗学院的创办人起初是为了帮助住在远方的亲人学习,所以特地录制了教学视频并上传至 YouTube 。由于其教学视频内容受到广泛好评,相关影片观看次数急速成长,受到鼓励的萨尔曼于2009年辞去工作,全职从事相关课程的录制,并在之后拥有了自己的独立网站。

美国的部分老师会让学生自行观看可汗学院教学视频,等第二天到了学校的课堂再向学生答疑、解惑以及探究,这种模式也被称作“翻转课堂”。其特点在于,让学生有了自主学习的空间,课堂上也出现了更多地师生以及生生互动,而非以老师讲授为主,被认为是一种更突出“以学生为中心”的教育理念。而 Khanmigo 的加入,则能让学生在可汗学院的网站上就能体验到课堂上与老师之间的对话互动,并且,这种互动会比真实课堂中的更加充分,因为是一对一。那么,未来有没有可能不需要人类教师了?

Khanmigo 目前处于测试阶段,最终效果还不得而知。AI 老师相比于人类老师而言,其不会有人类的种种情感,所以它能做到对学生一视同仁,不会对差生以及不听话的学生产生歧视和偏见等负面情感,光从这点来看,我个人还是比较希望未来的 AI 老师能够替代现在的人类老师来完成教学任务。但是,人类的老师对学生之间也会产生正面情感,例如:让学生感到被关注以及以身作则来影响学生等,我认为这可能是 AI 老师无法为学生带来的体验,虽然 AI 也能使用文字、声音甚至肢体动作来表达情感,但终究会有所差别。而为了能给学生一个健全的成长环境,也许未来会是AI 老师与人类老师共存的景况,但各自定位肯定会不同。

实际上,有关 AI 在教育领域应用的研究及实践早已有之。国际人工智能教育协会(IAIED)是一个处于计算机科学、教育和心理学领域前沿的跨学科团体,其提倡为所有年龄段、所有领域的学习者研究和开发互动以及适应性的学习环境。所谓适应性或自适应的学习环境,指的是根据学习者的反馈和表现,动态调整学习内容和方式,以达到更好的学习效果。显然,这需要利用技术手段实现,例如智能教育软件、自适应学习系统、个性化学习平台等,这些都要用到人工智能技术。

在我看来,Khanmigo 属于一种智能辅导系统,旨在通过自适应、个性化的方式辅助学生学习和教师的教学工作。这种系统可以根据学生的学习情况和需求,提供针对性的教学内容、练习和评估,并通过分析学生的学习数据,为学生和教师提供反馈和建议。只不过目前的 Khanmigo 可能更多只是在模拟人类教师,从而让学生能够与其产生师生间的各种互动,但未来大概率会往一个智能辅导系统方向发展。

人工智能的其中一种定义是“使机器能够像人类一样做需要智力才能完成的事情”,那么所谓将其应用至教育领域,也就是让它完成人类在教育领域中所做的事情,那么,可以将人工智能的教育应用场景概括为以下几个方面:

减少教师工作量

适应性课程

智能辅导

智能评估

总之,人工智能在教育领域中的应用早已出现,并非 ChatGPT 或 GPT-4 出来后才有所行动。但在机器的智能程度方面,过去机器的智能比之现今机器的智能自然相差甚远。同时,当未来人工智能技术发展成像电脑和互联网一样普及的时候,世界会是怎样一番景象?此时的教育又会面临哪些问题?还会存在教育公平问题吗?亦或是人工智能加剧了教育不公平现象?

参考资料:

文章

1、ChatGPT 和生成性人工智能(AI)的未来展望:来自教育领域的集体反思

一篇亚洲远程教育杂志征集的文章,文章讨论了使用 AI 在教育中可能出现的好处和潜在的负面影响,并强调了重新思考技术和人类教育者在教育中的角色。最后,文章表明,技术应该是支持人类教育者和学生的,而人类教育者的主导角色和意义不能被低估。毕竟教育是关于人的,所以应该由人来完成,而不是由任何技术代替人来完成。

2、生成式人工智能和(反)社会学习的潜力

该篇文章的核心思想是探讨生成 AI 在学习中的潜在影响,特别是在社会性学习(Social Learning)方面的影响。我对这篇文章的内容并没有特别理解,感觉作者是想利用 AI 技术来充当一个故事生成器,其能将人类的想象力具象化(图像、语言),让人们可以通过具象化出来的故事来交流、协作,以达到社会性学习的目的。总的来说,其主要描述了故事在学习中的作用,作者还写了这样一段话:

我们是由故事组成的:它们确实是我们与 "他人 "分享 "内在 "东西的唯一方式。当我告诉你我的感受、想法和愿望时,这些都是故事。我的购物清单是一个故事,就像我写的一首诗,或一份法律合同一样。

3、学校正在使用语音技术进行阅读教学,它有帮助吗?

文章介绍了教育技术公司利用基于基于语音的人工智能系统,来帮助提高从幼儿园到四年级学生的基础阅读技能。这种系统能为学生提供即时反馈,本质上是一种智能评估系统,好处是显而易见的,最直接的就是每个学生都拥有了一个能对其阅读能力提供指导的“老师”——纠正学生的发音、字母识别等潜在问题。并且,还能够发现存在阅读障碍的学生,同时将此信息上报给老师,以便老师及时做针对性处理。

我认为,这种智能评估系统,极大的降低了老师工作量,从而能够让老师有精力投入到更重要的工作当中。随着机器越来越聪明,想来定能够帮助老师做更多的评估工作,我原先还在想,什么时候能有这样一种 AI 工具——给它任意一篇文章,它能立刻根据文章内容生成一系列提问,最后根据我的回答来判断我是否真正理解了文章内容,同时还能引导我该怎样去正确理解。

4、在人工智能领域,规模大就一定好吗?

本文讨论了人工智能语言模型的大小是否决定了其解决需要推理的任务的能力,更大的模型在某些任务上表现更好,但也存在输出结果难以信任和高能耗等问题。一些研究人员呼吁关注更小、更节能的 AI 模型,其中一个观点称,相较于任何一个 LLM(大型语言模型),人类大脑更大更复杂,拥有860亿个神经元和约100万亿个突触连接,但消耗的功率约为20-50瓦。所以,科学家希望通过模拟大脑的一些方面,如它的递归或反馈连接,使 LLM 和其他神经网络变得更小、更智能、更高效。

我认为,虽然目前 AI 的热度很高,但我们也不得不正视其存在的这些问题——输出不完全可靠、高能耗、高成本等。其中,输出不完全可靠问题,在某些领域面临如何利用 AI 的考量时,是一个需要谨慎考虑的点。例如教育领域,如果让学习者完全依赖 AI 的输出的来学习,那很可能会加剧错误信息传播的风险,最终会造成哪些后果也并不可控。

虽然目前的 AI 有这样那样的问题,但在 ChatGPT 出现后,个人、企业以及政府组织对于 AI 的热情会有助于人工智能领域的发展。如果哪天在操作系统层面上默认集成 ChatGPT 这种程度的 AI,可能才意味着人工智能技术的真正成熟。

5、拥抱 AI,提高学生和员工的生产力

澳大利亚开放性远程教育理事会(ACODE)举办了一场研讨会,参会人员都是澳大利亚高等教育部门不同角色的代表,包括教学学术工作人员、教学设计师、技术人员、学习和教学主管以及学习支持专业人员。会议重点讨论了 AI 在学习、教学和评估方面的促进因素与障碍,最后也总结了八点实践建议。此外,根据组织者的调查,机构最关心的是 AI 导致的学术诚信(学生使用 AI 完成作业、论文)问题,但是,大多数机构还是倾向于让学生使用这些人工智能工具。

不过在我看来,学校大概率还是会对 ChatGPT 这种 AI 技术持保守态度,有可能小面积使用,但真要在教学工作中全面拥抱,感觉还不太可能。但教育领域不仅仅有线下传统学校,还涉及线上学习平台、课外辅导、企业培训等机构,我相信,相对于传统学校,这些机构会更早全面拥抱 AI。

教育之美

这部视频里的学生是老师扮演的,而老师则由学生扮演:

虽然视频存在搞笑成分,但也比较真实,评论值得浏览:

对这条评论印象深刻——怎么会有人喜欢当老师呢?

我相信是有人真心喜欢当一名教师的,也相信会存在许多不好教的学生,特别是在中小学,如果学校教育让孩子感受到的是一种束缚,则可能越加导致其变成“问题”学生。这种情况下,老师的作用就越发重要,但具体该如何教呢?可能就如一条评论所说“你必须能够与你的学生打成一片,并尊重他们”,我想这只有热爱教师这份职业的人才更有可能做到。

👋🏻 觉得本期有收获?

转发给朋友看看或推荐好友订阅

Copyright 2023 EdTech Thinking Contact: octo@eeoa.com

This work is licensed under a Creative Commons License.